一. 大页(HugePages)概念

Hugepage的引入

二. hugepages相关概念

三.Regular Pages 与 HugePages

a、Regular Pages

b、Huge Pages

四. hugepage 优点

五.调优方法

5.1 在Host侧查看各个numa节点上的大页分配情况。

5.2 配置虚拟机使用512MB内存大页。

5.3 重启服务器。

5.4 重新进入操作系统后,确定内存大页配置情况。

5.5 确定hugetlbfs是否已经挂载。

5.6 虚拟机配置大页内存,xml配置参考如下:

一. 大页(HugePages)概念

HugePages是通过使用大页内存来取代传统的 4kb 内存页面,使得管理虚拟地址数变少,加快了从虚拟地址到物理地址的映射以及通过摒弃内存页面的换入换出以提高内存的整体性能。

尤其是对于8GB以上的内存以及较大的 Oracle SGA size,建议配值并使用 HugePage特性。

Hugepage的引入

操作系统对于数据的存取直接从物理内存要比从磁盘读写数据要快的多,但是物理内存是有限的,这样就引出了物理内存与虚拟内存的概念。

虚拟内存就是为了满足物理内存的不足而提出的策略,它是利用磁盘空间虚拟出的一块逻辑内存,这部分磁盘空间Windows下称之为虚拟内存,Linux下被称为交换空间(Swap Space)。

对于这个大内存的管理(物理内存+虚拟内存),大多数操作系统采用了分段或分页的方式进行管理。

分段是粗粒度的管理方式,而分页则是细粒度管理方式,分页方式可以避免内存空间的浪费。

相应地,也就存在内存的物理地址与虚拟地址的概念。通过前面这两种方式,CPU必须把虚拟地址转换程物理内存地址才能真正访问内存。

为了提高这个转换效率,CPU会缓存最近的虚拟内存地址和物理内存地址的映射关系,并保存在一个由 CPU 维护的映射表中。

为了尽量提高内存的访问速度,需要在映射表中保存尽量多的映射关系。

linux 的内存管理采取的是分页存取机制,为了保证物理内存能得到充分的利用,内核会按照 LRU 算法在适当的时候将物理内存中不经常使用的内存页自动交换到虚拟内存中,而将经常使用的信息保留到物理内存。

通常情况下,Linux默认情况下每页是 4K,这就意味着如果物理内存很大,则映射表的条目将会非常多,会影响CPU的检索效率。

因为内存大小是固定的,为了减少映射表的条目,可采取的办法只有增加页的尺寸。因此Hugepage便因此而来。也就是打破传统的小页面的内存管理方式,使用大页面 2M,4M,16M等等。

如此一来映射条目则明显减少。如果系统有大量的物理内存(大于8G),则物理32位的操作系统还是64位的,都应该使用Hugepage。

二. hugepages相关概念

Page Table(页表): page table也就是一种用于内存管理的实现方式,用于物理地址到虚拟之间的映射。因此对于内存的访问,先是访问Page Table,然后根据Page Table 中的映射关系,隐式的转移到物理地址来存取数据。

TLB: Translation Lookaside Buffer (页表缓存) ,CPU中的一块固定大小的 cache,包含了部分page table的映射关系,用于快速实现虚拟地址到物理地址的转换。

Hugetlb: hugetlb 是TLB中指向HugePage的一个entry(通常大于4k或预定义页面大小)。

HugePage 通过hugetlb entries来实现,也可以理解为HugePage 是hugetlb page entry的一个句柄。

Hugetlbfs: 一个类似于tmpfs的新的in-memory filesystem,在2.6内核被提出。

三.Regular Pages 与 HugePages

a、Regular Pages

在下图中有两个不同的进程,两个进程对于内存的访问是首先访问本地的page table,而本地的page table又参照了system-wide table的page(也就是前面描述的TLB),最终system-wide table中的entry指向了实际的物理地址。

图中物理地址page size大小4kb。也可以看到进程1和进程2在system-wide table中都指向了page2,也就是同一个物理地址。Oracle sga中共享内存的使用会出现上述情形。

b、Huge Pages

在下图中,本地的page table 与system page table中都包含了huge page属性。因此page table中的任意一个page可能使用了常规的page,

也有可能使用了huge page。同样进程1和进程2都共享了其中的Hpage2。图中的物理内存常规的page size是4kb,huge page size 是4mb。

四. hugepage 优点

对于较大的系统内存以及sga,使用hugepage可以极大程度的提高Oracle数据库性能。

a、Not swappable

无需交换。也就是不存在页面由于内存空间不足而存在换入换出的问题

b、Relief of TLB pressure

减轻TLB的压力,也就是降低了cpu cache可缓存的地址映射压力。由于使用了huge page,相同的内存大小情况下,管理的虚拟地址数量变少。

TLB entry可以包含更多的地址空间,cpu的寻址能力相应的得到了增强。

c、Decreased page table overhead

降低page table负载,对于普通的page,每个entry需要64bytes进行管理,对于50gb的内存,管理这些entry,需要800mb的大小

(50*1024*1024)kb/4kb*64bytes/1024/1024=800mb。

d、Eliminated page table lookup overhead

消除page table查找负载

e、Faster overall memory performance

提高内存的整体性能

五.调优方法

使用内存大页的好处是能保证虚拟机的所有内存在Host上始终以大页形式存在,并且保证物理连续,可以有效的减少TLB Miss,显著提升内存访问密集型业务的性能。

在虚拟机使用内存大页的场景下,通过关闭透明大页(参见关闭透明大页),可以减少Host侧的开销,使得虚拟机可以获得更稳定的性能。

说明:

不同OS对于内存大页的单位设置会不一样,UVP一般设置1G,而本文提及的 CentOS 7.6则设置为 512MB。虚拟化场景,配置内存大页时,至少要预留总内存的15%给Host。

5.1 在Host侧查看各个numa节点上的大页分配情况。

cat /sys/devices/system/node/node*/meminfo | grep Huge

如果HugePages显示信息为0,说明此时系统没有配置内存大页。

5.2 配置虚拟机使用512MB内存大页。

须知:

KVM虚拟化场景下,配置内存大页时,至少要预留总内存的15%给Host。

以 32U180G 规格配置虚拟机为例,先在Host(物理机)侧分配300个512MB内存大页。

a) 对于CentOS 7.6操作系统,编辑 /boot/efi/EFI/centos/grub.cfg。

vim /boot/efi/EFI/centos/grub.cfg

b) 在Linux行输入以下配置。

default_hugepagesz=512M hugepagesz=512M hugepages=300

如下所示:

5.3 重启服务器。

reboot

5.4 重新进入操作系统后,确定内存大页配置情况。

cat /proc/sys/vm/nr_hugepages

说明:

此时各个NUMA节点的HugePages显示信息为75,说明此时系统已为各个NUMA节点(numa0~node3)配置了75个512MB内存大页。

如果需要查看某个NUMA节点上的大页配置情况,可以执行如下命令:

这里以node0为例:

cat /sys/devices/system/node/node0/hugepages/hugepages-524288kB/nr_hugepages

cat /sys/devices/system/node/node0/hugepages/hugepages-524288kB/free_hugepages

说明:

nr_hugepages显示信息为75,说明此时系统为该numa节点配置了75个512MB内存大页;free_hugepages显示信息为75,说明此时系统剩余75个512MB内存大页。

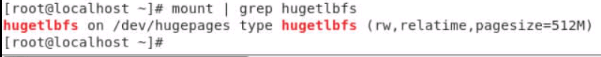

5.5 确定hugetlbfs是否已经挂载。

mount | grep hugetlbfs

上述回显信息表示已经挂载上了。

5.6 虚拟机配置大页内存,xml配置参考如下:

- <domain type = 'KVM'>

- ...

- <memory unit='KiB'>8388608</memory>

- <currentMemory unit='KiB'>83886088</currentMemory>

- <memoryBacking>

- <hugepages/>

- </memoryBacking>

- <vcpu placement = 'static' cpuset='12-15'>4</vcpu>

- <cputune>

- <vcpupin vcpu='0' cpuset='12'/>

- <vcpupin vcpu='1' cpuset='13'/>

- <vcpupin vcpu='2' cpuset='14'/>

- <vcpupin vcpu='3' cpuset='15'/>

- <emulatorpin cpuset='12-15'/>

- </cputune>

- <numatune>

- <memnode cellid='0' mode='strict' nodeset='0'/>

- </numatune>

- ...

- </domain>