为了节省个人计算机空间,我们经常将一些文件上传到网盘。但是如果没有开通VIP,上传文件大小往往受限。今天我就遇到了这个问题,在将Matlab安装包上传至百度网盘时,大小超出限制。如图

![]()

文件有20G,但是上传单个文件大小限制为4G。此时就希望能够将上述文件拆分成多个压缩文件上传至网盘,也就是分卷压缩。

由于我采用的是7-zip文件压缩工具,所以下面只介绍基于7-zip的分卷压缩和解压方法。

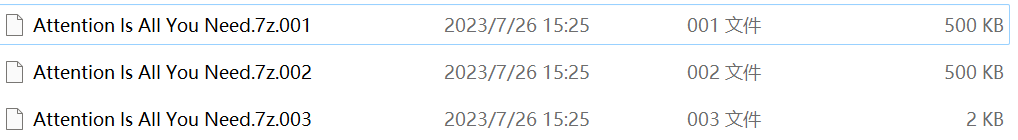

以PDF格式的论文"Attention Is All You Need"为例进行分卷压缩,其大小为2151KB。采用分卷压缩方法,将其压缩为单卷最大500KB的多个压缩文件。步骤如下:

1. 右键7-zip,选择添加到压缩包

2. 设置分卷大小为500KB(指的是压缩后的文件最大为500KB而不是最大压缩500KB文件),确定运行

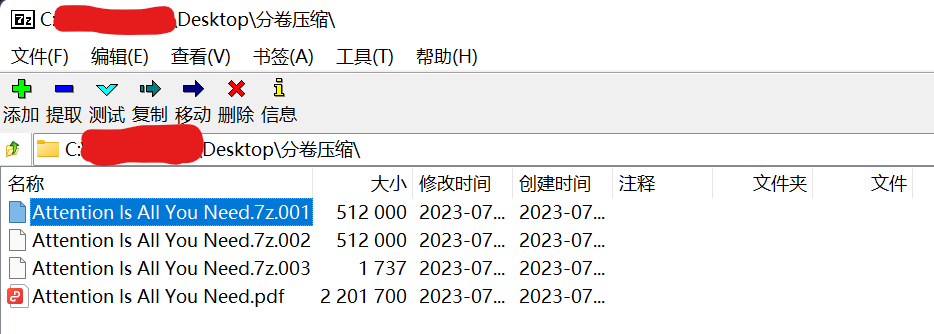

3. 此时在原目录下会生成多个压缩文件,以编号区分

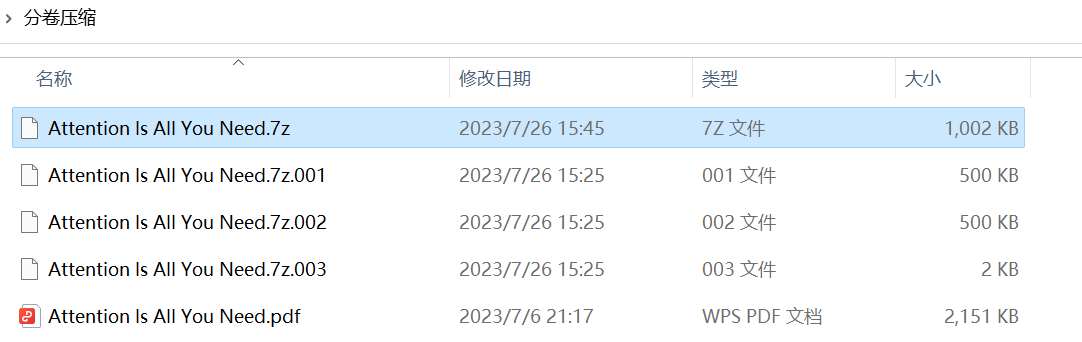

4. 将分卷压缩结果打包放在同一目录下即完成压缩

1. 开始菜单输入7-zip,运行7-zip工具

2. 地址栏定位到前面的分卷压缩结果存储目录,选中第一个压缩文件

3. 选择右键->合并文件

4. 选择合并文件存放路径后确定

5. 路径下会生成合并后的压缩文件

6. 解压后即可恢复原文件,此处将恢复的文件命名为"Attention Is All You Need2.pdf"。

7. 利用MD5的方式可知原文件和新文件哈希值一致,表明两文件一样,证明这种方法是没问题的。

本文至此结束,如有疑惑欢迎留言交流。